Nga Gazeta Si- Imazhet e gjeneruara nga inteligjenca artificiale të varfërisë ekstreme, fëmijëve dhe të mbijetuarve të dhunës seksuale po mbushin faqet e fotografive dhe po përdoren gjithnjë e më shumë nga OJQ-të kryesore, sipas profesionistëve globalë të shëndetit të cilët kanë shprehur shqetësim për një epokë të re të “pornografisë së varfërisë”.

“Kudo, njerëzit po e përdorin atë,” thotë Noah Arnold, i cili punon në Fairpicture, organizatë në Zvicër e fokusuar në promovimin e imazheve etike në zhvillimin global.

“Disa po përdorin në mënyrë aktive imazhe të inteligjencës artificiale, dhe të tjerët, ne e dimë se të paktën po eksperimentojnë.”

Arsenii Alenichev, studiues në Institutin e Mjekësisë në Antwerp që studion prodhimin e imazheve globale të shëndetit, tha se imazhet tregojnë varfëri ekstreme, ku përmbajnë fëmijë me pjata bosh, tokë të ndotur dhe pamje aspak të këndshme për tu parë.

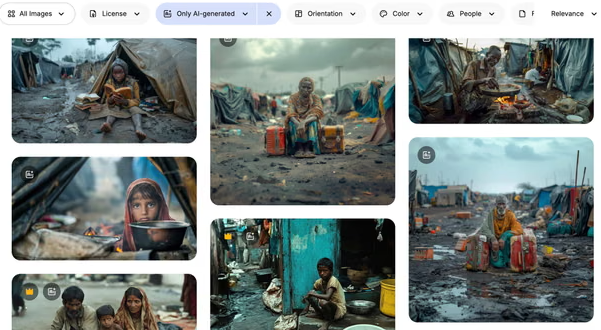

Alenichev ka mbledhur më shumë se 100 imazhe të gjeneruara nga inteligjenca artificiale të varfërisë ekstreme të përdorura nga individë ose OJQ si pjesë e fushatave të mediave sociale kundër urisë ose dhunës seksuale. Imazhet që ai ndau me Guardian tregojnë skena të ekzagjeruara, që përjetësojnë stereotipet: fëmijë të mbledhur së bashku në ujë me baltë; një vajzë afrikane me një fustan nusërie me një lot që i rrjedh në faqe. Në një koment të botuar në Lancet Global Health, ai argumenton se këto imazhe përbëjnë “pornografi varfërie 2.0”.

Ndërsa është e vështirë të përcaktohet sasia e përhapjes së imazheve të gjeneruara nga IA, Alenichev dhe të tjerë thonë se përdorimi i tyre është në rritje, i nxitur nga shqetësimet mbi pëlqimin dhe koston. Arnold tha se shkurtimet e fondeve të SHBA-së për buxhetet e OJQ-ve i kishin përkeqësuar gjërat.

“Është mjaft e qartë se organizata të ndryshme po fillojnë të marrin në konsideratë imazhet sintetike në vend të fotografisë reale, sepse është e lirë dhe nuk kanë nevojë të mendojnë për asgjë tjetër”, tha Alenichev.

Imazhet e gjeneruara nga IA të varfërisë ekstreme tani shfaqen me dhjetëra në faqet e njohura të fotografive, duke përfshirë Adobe Stock Photos dhe Freepik, në përgjigje të pyetjeve të tilla si “varfëria”. Shumë prej tyre mbajnë mbishkrime të tilla si “Fëmijë në kamp refugjatësh”; “Fëmijët aziatikë notojnë në një lumë plot me mbeturina”; dhe “Fëmijë të vegjël me ngjyrë në fshatin afrikan”. “Kjo nuk duhet të ndodhte kurrë pasi janë stereotipet më të këqija për Afrikën dhe cdo vend tjetër”, thotë Alenichev.

Joaquin Abela, CEO i Freepik, tha se përgjegjësia për përdorimin e imazheve të tilla ekstreme bie mbi konsumatorët e medias dhe jo mbi platformat si e tija. Fotot e stokut të IA-së, tha ai, gjenerohen nga komuniteti global i përdoruesve të platformës, të cilët mund të marrin një tarifë licencimi kur klientët e Freepik zgjedhin të blejnë imazhet e tyre.

Në të kaluarën, organizatat kryesore bamirëse kanë përdorur imazhe të gjeneruara nga IA si pjesë e strategjive të tyre të komunikimit mbi shëndetin global. Në vitin 2023, dega holandeze e organizatës Plan International publikoi një fushatë video kundër martesës së fëmijëve që përmbante imazhe të gjeneruara nga IA të një vajze me sy të nxirë, një burri të moshuar dhe një adoleshenteje shtatzënë.

Vitin e kaluar, OKB-ja postoi një video në YouTube me “ri-interpretime” të gjeneruara nga IA të dhunës seksuale, e cila përfshinte dëshmi të gjeneruara nga IA nga një grua nga Burundi që përshkruante se ishte përdhunuar nga tre burra dhe ishte lënë të vdiste në vitin 1993 gjatë luftës civile të vendit. Videoja u hoq pasi Guardian kontaktoi OKB-në për koment.

Një zëdhënës i Paqeruajtjes së OKB-së tha: “Videoja në fjalë, e cila u prodhua më shumë se një vit më parë duke përdorur një mjet që evoluon me shpejtësi, është hequr, pasi besuam se tregonte përdorim të papërshtatshëm të IA-së dhe mund të paraqiste rreziqe në lidhje me integritetin e informacionit, përzierjen e pamjeve reale dhe përmbajtjes artificialisht të gjeneruar pothuajse reale”.

Arnold tha se përdorimi në rritje i këtyre imazheve të inteligjencës artificiale vjen pas viteve të tëra debatesh në sektor rreth imazheve etike dhe rrëfimit dinjitoz të historive rreth varfërisë dhe dhunës. “Me sa duket, është më e lehtë të marrësh pamje të gatshme të inteligjencës artificiale që vijnë pa pëlqimin e tyre, sepse nuk janë njerëz të vërtetë.”

Kate Kardol, konsulente komunikimi për OJQ-të, thotë se këto imazhe e frikësojnë dhe kujtoi debatet e mëparshme rreth përdrorimit të “pornografisë së varfërisë” në këtë sektor.

“Më trishton fakti që lufta për një përfaqësim më etik të njerëzve që përjetojnë varfëri tani shtrihet deri në joreale,” tha ajo.

Mjetet gjeneruese të IA-së prej kohësh janë gjetur se kopjojnë dhe ndonjëherë ekzagjerojnë paragjykime më të gjera shoqërore.

Përhapja e imazheve të paragjykuara në komunikimet globale shëndetësore mund ta përkeqësojë problemin, tha Alenichev, sepse imazhet mund të filtrohen në internetin më të gjerë dhe të përdoren për të trajnuar gjeneratën e ardhshme të modeleve të IA-së, një proces i cili është treguar se amplifikon paragjykimet.

Copyright © Gazeta “Si”

Të gjitha të drejtat e këtij materiali janë pronë ekskluzive dhe e patjetërsueshme e Gazetës “Si”, sipas Ligjit Nr.35/2016 “Për të drejtat e autorit dhe të drejtat e tjera të lidhura me to”. Ndalohet kategorikisht kopjimi, publikimi, shpërndarja, tjetërsimi etj, pa autorizimin e Gazetës “Si”, në të kundërt çdo shkelës do mbajë përgjegjësi sipas nenit 179 të Ligjit 35/2016.

.png)