Gazeta Si – Ndërsa analizonte imazhet e CT të trurit, një AI e Google shpiku një pjesë anatomike inekzistente, duke shkruar një raport që më vonë u përfshi në një studim shkencor mbi dobinë e AI-së në diagnozat mjekësore.

Gabimi u vu re nga një neurolog i cili nuk ishte i përfshirë në studim dhe u korrigjua vetëm pjesërisht nga Google, i cili u përpoq të minimizonte rëndësinë e tij.

Historia, e raportuar nga disa faqe interneti të teknologjisë dhe shëndetit, është emblematike se si inteligjenca artificiale, pavarësisht se tregon potencial të madh në fushën mjekësore, mund të gjenerojë rezultate mashtruese nëse nuk mbikëqyret siç duhet.

Përtej shkrimit, vizatimit, redaktimit të imazheve dhe kompozimit të muzikës, sistemet e inteligjencës artificiale (IA) pritet të përdoren gjithnjë e më shumë në fusha të shumta, përfshirë kujdesin shëndetësor.

Disa nga zhvilluesit më të mëdhenj, si OpenAI dhe Google, kanë argumentuar prej kohësh se AI e tyre mund të përdoret jo vetëm në zhvillimin e barnave të reja, por edhe për të ndihmuar mjekët të bëjnë diagnoza më të sakta dhe më të sakta.

Ka mundësi dhe entuziazëm të madh rreth kësaj mundësie, por disa mjekë dhe ekspertë të AI-së kërkojnë kujdes dhe pranojnë kufizimet e aplikacioneve aktuale diagnostikuese.

Për më shumë se një vit, Google ka promovuar progresin dhe rezultatet e arritura nga Med-Gemini, një grup modelesh multimodale (domethënë, modele që kombinojnë elementë të shumtë, siç janë informacionet nga imazhet, teksti dhe burime të tjera) të specializuara në mjekësi.

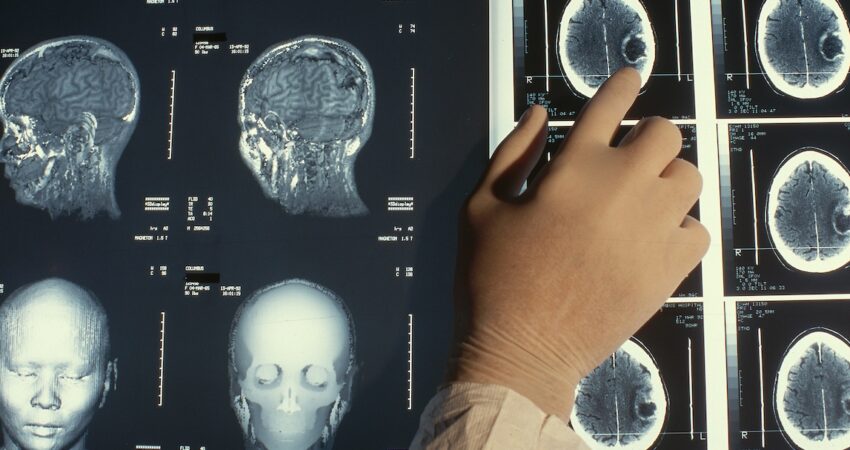

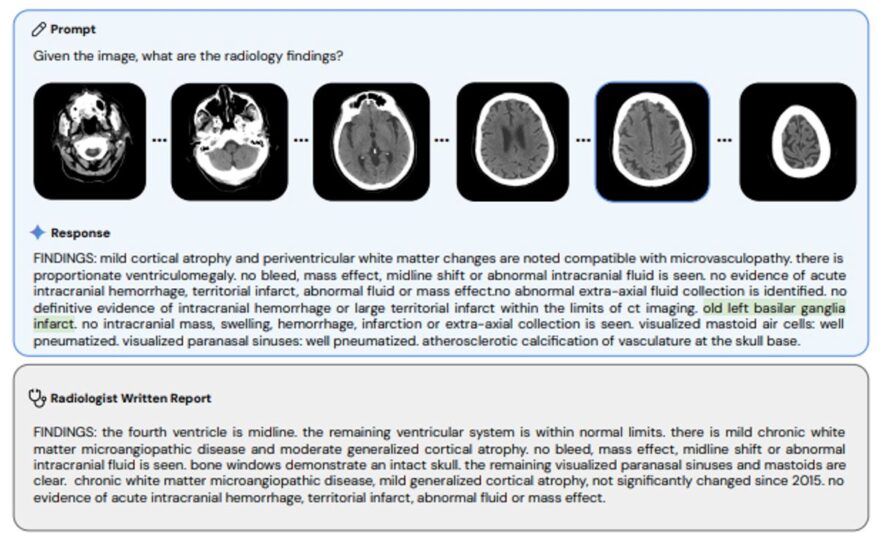

Ky sistem mund të përmbledhë tekste mjekësore, të vlerësojë simptomat e raportuara nga një pacient për të provuar një diagnozë dhe është gjithashtu i aftë të analizojë imazhe të tilla si rrezet X, skanimet CT dhe MRI-të, duke zbuluar anomali dhe duke i raportuar ato te mjekët.

Kjo detyrë e fundit është kryer nga disa inteligjenca artificiale të tjera të disponueshme për njëfarë kohe dhe ka rezultuar shumë premtuese, me teste që tregojnë se sistemet e analizës së imazhit ndonjëherë panë gjëra që radiologët nuk i kishin parë. Por gjërat nuk shkojnë gjithmonë mirë.

Inteligjencat artificiale mund të halucinojnë dhe për këtë arsye të raportojnë diçka që nuk ekziston, ose të shpikin një pjesë anatomike tërësisht, me të gjitha rreziqet që mund të sjellin nëse mjekët që përdorin këto softuerë bëjnë vlerësime të pakujdesshme.

Med-Gemini e bëri këtë duke krijuar një pjesë të trurit që nuk ekziston dhe e cila më pas përfundoi në një studim shkencor, i cili përshkroi progresin e arritur nga ajo inteligjencë artificiale.

Për të kuptuar problemin, nevojitet një mësim i shpejtë mbi anatominë. Ganglionet bazale janë një strukturë e trurit e përbërë nga neurone të vendosura në bazën e trurit dhe janë të përfshira në funksione të shumta, të tilla si kontrolli i lëvizjes, të mësuarit dhe menaxhimi emocional.

Arteria bazilare, nga ana tjetër, është një enë gjaku që çon gjak në struktura të shumta të trurit. Prandaj, ato kanë funksione shumë të ndryshme dhe për këtë arsye kërkojnë trajtime të ndryshme në varësi të problemeve të mundshme.

Halucinacioni i Med-Gemini përbëhej nga shpikja e “ganglioneve bazilare”, një pjesë anatomike joekzistente.

Gabimi nuk u vu re nga ata që shqyrtuan raportin, as nga ata që më pas përgatitën studimin shkencor mbi aftësitë e AI-së së Google në fushën mjekësore.

“Ganglionet bazale” gjithashtu përfunduan në blogun zyrtar të kompanisë në maj 2024, në një artikull informues që ilustronte pikat kryesore të studimit në mënyrë që të nxirrte në pah progresin e bërë me AI-në e re.

Siç raportohet nga faqja e internetit e teknologjisë “The Verge”, gabimi u vu re më vonë nga një neurolog i cili kishte kryer kërkime me inteligjencën artificiale. Ai njoftoi Google, i cili e redaktoi artikullin popullor pa i njoftuar ata se e kishte korrigjuar gabimin, i cili, për më tepër, mbeti i pranishëm në studimin shkencor.

Neurologu vuri në dukje publikisht se artikulli ishte korrigjuar pa ndonjë informacion të ri, dhe vetëm atëherë Google e ndryshoi atë përsëri, duke shtuar një shpjegim që do t’i kishte hutuar shumë mjekë: “Vini re se ‘basal’ është një gabim i zakonshëm transkriptimi i fjalës ‘basal’ që Med-Gemini mësoi nga të dhënat e tij të trajnimit, edhe pse kuptimi i raportit të tij mbetet i njëjtë.” Prandaj, Google e konsideroi atë më shumë si një gabim shtypi sesa një halucinacion.

Duke përdorur një motor kërkimi shkencor të madh si Google Scholar, ka më pak se njëqind rezultate për “ganglionet bazilare”, ndërsa ka gati 900,000 rezultate për “ganglionet bazale” dhe gati 150,000 për “arterien bazilare”.

Gjatë trajnimit të tij, Med-Gemini do të duhej të analizonte shumë më tepër tekste që përmbanin dy versionet e sakta sesa ato pak me gabimin, kështu që është e paqartë pse në atë rast specifik prodhoi një term që nuk ka kuptim mjekësor.

Jeta e askujt nuk u vu në rrezik nga gabimi, por sjellja anormale e inteligjencës artificiale nuk duhet nënvlerësuar, veçanërisht në fushën mjekësore.

Në një seri testesh, disa mjekë vunë re se modele të tjera, të tilla si MedGemma, gjithashtu e zhvilluar nga Google, i ndryshojnë ndjeshëm përgjigjet e tyre në varësi të mënyrës se si u bëhen pyetje, duke prodhuar kështu raporte të ndryshme për të njëjtat imazhe të analizuara.

Nëse kërkesa, d.m.th., teksti që përmbante kërkesën, përfshinte detaje të gjera të pacientit, inteligjenca artificiale ofronte një diagnozë të saktë të problemit, ndërsa për një kërkesë më të paqartë, sistemi nuk arrinte të zbulonte ndonjë problem shëndetësor edhe pse ato ishin të dukshme në rrezet X.

Kompanitë e mëdha të teknologjisë që qëndrojnë pas modeleve më të njohura, si ChatGPT dhe Gemini, thonë se inteligjenca artificiale e tyre duhet të shihet si një ndihmë për mjekët, jo si një zëvendësim, duke nënkuptuar se vendimi përfundimtar i mbetet mjekut, si në aspektin e diagnozave ashtu edhe të trajtimeve që do të përshkruhen.

Por edhe këtu, mund të ketë probleme. Inteligjenca artificiale do të përdoret gjithnjë e më shumë për të shkruar raporte dhe receta, duke i bërë ato më të lehta për t’u kuptuar nga pacientët dhe më të shpejta për t’u plotësuar nga mjekët.

Mjekët do të jenë gjithmonë përgjegjës për korrigjimin e tyre për t’u siguruar që Inteligjenca Artificiale nuk ka keqkuptuar ose shpikur një pjesë, me rrezikun që me recetën e njëqindtë të ngjashme, mjeku mund të humbasë diçka, me rreziqe që variojnë nga minimale në shumë serioze për pacientin.

Zhvilluesit e modeleve shpesh theksojnë se vetëm në pak vite, ka pasur përparime të mëdha në saktësinë e tyre, ndërsa prevalenca e gabimeve njerëzore në fushën mjekësore mbetet pak a shumë e qëndrueshme. Këto gabime mund të reduktohen falë përhapjes së Inteligjencës Artificiale.

Nuk ka mungesë potenciali dhe disa përvoja premtuese janë tashmë të disponueshme. Ekzistojnë gjithashtu propozime për të parandaluar një “garë drejt inteligjencës artificiale” siç ka ndodhur tashmë në sektorë të tjerë, në mënyrë që kostot dhe mundësitë e përdorimit të tyre në kujdesin shëndetësor të studiohen dhe analizohen më mirë.

Siç shpjegoi për “The Verge”, Jonathan Chen, profesor i asociuar në Shkollën e Mjekësisë të Stanfordit: “Është një kohë vërtet e çuditshme, ku shumë nga këto gjëra po përvetësohen shumë shpejt në mjediset klinike. Ato nuk janë pjekur ende. […] Kur kemi të bëjmë me mjekësinë, diçka e papërsosur mund të duket e patolerueshme”.

Përshtati: Gazeta “Si”

Copyright © Gazeta “Si”

Të gjitha të drejtat e këtij materiali janë pronë ekskluzive dhe e patjetërsueshme e Gazetës “Si”, sipas Ligjit Nr.35/2016 “Për të drejtat e autorit dhe të drejtat e tjera të lidhura me to”. Ndalohet kategorikisht kopjimi, publikimi, shpërndarja, tjetërsimi etj, pa autorizimin e Gazetës “Si”, në të kundërt çdo shkelës do mbajë përgjegjësi sipas nenit 179 të Ligjit 35/2016.

.png)